华为的三个黑科技,要颠覆AI计算?

没有人不在期待大模型能够成为下一个电动车,作为代表中国的新兴产业,在世界范围内掀起狂澜。

然而主流的MoE架构大模型,却苦于其结构上的“先天不足”:巨大的硬件成本与多重拖累效率的环节,使得中国企业在这场芯片堆砌与效率挖掘的苦径上难以提速。

作为智能基础设施提供商,华为在这场战役中另辟蹊径,利用其在数学算法和工程领域的深厚积累,为DeepSeek显著提升了效率及用户体验。

山就在那里,但中国企业找到了不一样的登顶之路。

近期,虎嗅将打造《华为技术披露集》系列内容,全面揭秘超大规模MoE模型推理部署技术,通过一连串的技术报告,首次全面披露技术细节。

希望本系列内容能为业界起到参考价值,也希望更多人能与华为一起,共同打造长期持续的开放协作生态环境,让昇腾生态在中国茁壮成长。

《华为技术披露集》系列

VOL.5 :昇腾亲和

算子是 AI 大模型执行计算的 “原子级工具”,如同乐高积木中的基础模块,负责从加减乘除到特征提取的一切核心操作。

它们不仅是模型的效率引擎,更是硬件性能的放大器 —— 通过标准化设计、硬件深度适配与复用机制,让芯片处理海量数据时如虎添翼。而昇腾此次开源的三大技术,正是算子优化的 “终极形态”。

AMLA × 融合算子 × SMTurbo:让大模型推理速度与能效双重革命

基于昇腾算力,华为团队本次发布了三项重要的硬件亲和算子技术研究:

AMLA:用“数学魔法”重构浮点运算,让昇腾芯片的算力利用率突破 70%。

融合算子优化:像指挥交响乐团一样调度硬件资源,让计算与通信 “无缝协奏”。

SMTurbo:打造内存访问的 “高速公路”,跨 384 卡延迟低至亚微秒级。

技术全景:三大黑科技如何颠覆 AI 计算?

AMLA:以加代乘的“魔法”让芯片算力利用率飙升

“数字炼金术”:对二进制表示重解析,将复杂乘法转换为加法运算,充分利用存内算力,算力利用率飙升至 71%。

针对Decode阶段的MLA计算,华为团队提出了AMLA(Ascend MLA)算子,通过数学等价变化和硬件亲和的深度优化,释放昇腾芯片澎湃算力。

具体而言,通过对浮点数二进制编码的重解析,把复杂的乘法运算变成简单的加法操作,AMLA实现了基于存内计算的变量更新,充分利用算力的同时减少数据搬运;结合一系列基于昇腾硬件的计算流程及流水优化手段,进一步提升算子的整体性能。

当前AMLA算法的Attention 算子充分发挥昇腾硬件的计算能力,平均算力利用率达到55%,最高可达71%,优于FlashMLA公开的结果。

融合算子优化:硬件资源的 “交响乐指挥家”

将多个算子合而为一,让计算、通信、存储 “三重协奏”。

基于昇腾平台部署 DeepSeek V3/R1 大模型的实践经验,华为团队提炼出三大昇腾算子融合设计原理:硬件单元间并行度优化、冗余数据搬运消除、数学等价重构计算流。

首先,利用昇腾芯片的多硬件单元并行的能力,将跨硬件单元串行算子融合为复合算子,通过指令级流水编排实现计算耗时相互掩盖。

其次,对串行向量算子实施融合处理,构建全局内存与计算单元缓存的直通数据通道,使中间结果全程驻留高速缓存。

最后,华为团队运用数学等价关系解耦算子间数据依赖,重构计算顺序实现并行加速。该技术体系在模型推理中实现了大幅性能提升。

SMTurbo:384 卡内存共享的 “超低延迟高速公路”

昇腾原生 Load/Store 语义让跨卡访存延迟进入亚微秒时代。

华为CloudMatrix 384支持384卡规模原生Load/Store语义。因其低延迟、上下文切换代价小、可细粒度流水等优势,受到业界广泛关注。基于共享内存的集合通信满足了小数据量、大范围集合通信场景需求,成为稀疏模型推理的关键能力。

面向原生Load/Store内存语义通信提供软硬件加速能力,ShmemTurbo Concurrent Push & Pull (SMTurbo-CPP) 将Load/Store在读和写两个方向上并行,发挥了昇腾芯片读写分离的微架构优势。

针对数据保序场景下的同步开销问题,引入了批处理与中转机制,降低了控制逻辑的开销。在跨机访存通信场景下,方案可以提升CloudMatrix 384中昇腾芯片每线程的访存吞吐20%以上。

写在最后

如上,在提到的三个算子层面优化技术的未来发展上:

针对AMLA,将研究仅KVCache 量化和全量化场景的MLA 算子优化,进一步扩展算子应用场景。

针对融合算子优化,将进一步探索融合算子在更多模型架构上的应用,推动大语言模型在昇腾硬件上的高效推理与广泛应用。

针对Load/Store的优化技术,将结合业务设计精巧的流水实现,平衡读写平面的负载分担,将CPP 思想引入Deepseek dispatch 与combine 场景,在大BatchSize下取得实际收益。

本内容为作者独立观点,不代表虎嗅立场。未经允许不得转载,授权事宜请联系 hezuo@huxiu.com

本文来自虎嗅,原文链接:https://www.huxiu.com/article/4383770.html?f=jinritoutiao

华为曝光两大黑科技!打破推理延迟魔咒,大模型从此「秒回」

编辑:编辑部 XYH

【新智元导读】刚刚,昇腾两大技术创新,突破速度瓶颈重塑AI推理。FusionSpec创新的框架设计配合昇腾强大的计算能力,将投机推理框架耗时降至毫秒级,打破延迟魔咒。OptiQuant支持灵活量化,让推理性价比更高。

「前DeepSeek」时代,人们普遍认为「有卡才能推理,没卡寸步难行」。

而DeepSeek却凭借一系列软件层面的架构创新,把这一硬性门槛直接抬走,同时开创了中国人自己的AI大航海时代。

不过,虽然诸如V3和R1等超大规模MoE性能卓越,但在部署时却存在着非常大的挑战——推理的速度和延迟。

心理学和行业实验一致表明,LLM吐出第一个token所用的时间(TTFT),以及每秒生成的速度直接决定了用户的「等候感」。超过100毫秒即可感知,超过2秒即可打断思考。

对于AI应用来说,这里有一个简单的公式可以说明:更快速度+更低延迟=更高满意度+更高转化率。

为了解决这一核心问题,华为通过两个全新的方法和思路,对MoE模型进行了专门的推理优化,让中国模型在中国的服务器上的推理速度 来到了全新的高度!

FusionSpec 打破了大模型推理「延迟魔咒」,依托于昇腾「超高」计算带宽比的特点,创新性地重塑了主模型和投机模型的流程,结合轻量级步间准备,将投机推理框架耗时做到了1ms。OptiQuant 不仅支持主流量化算法,同时具备灵活的自定义组合能力,涵盖了业内主流评测数据集,为大模型推理提供了更强性价比。

华为挑战MoE推理的「两把刷子」

早期LLM的推理通常使用自回归解码方式,即「每次只能预测下一个token」。

且需将历史输出作为输入进行下一步解码,导致推理过程串行、效率低下、计算密集度低。

如何解决这个问题?投机推理技术 应运而生。

投机推理(Speculative Inference),也被称为推测性解码,其核心思想是利用计算代价远低于大模型的小模型(也称为投机模型),先行对后续可能的输出进行猜测,然后由大模型对这些猜测结果进行验证,从而实现并行化推理,提升整体推理速度。

这个道理其实也简单,就像写作文的时候,你先在草稿上「预测」几个可能句子(投机模型猜测),再挑出合适的句子写到正式作文里(大模型或者叫主模型验证)。

如果草稿上预测的都不对,那就把作文里的擦掉重写就好了(回退修正)。但要是预测对了,写作文的速度(大模型的输出速度)就能更快——毕竟草稿纸上的修改成本远低于正式作文。

这种「先试错再优化」的思路,让大模型能更快、更准的给出答案(也就是推理速度又快又好)。

然而,是想要完美将投机模型和主模型相结合,依然面临很大的困难。

1. 推测准确性与草稿生成效率的权衡

小模型的主要任务是快速生成可能的输出,但这往往与生成结果的准确性相矛盾。如何在两者之间找到最佳平衡点,是投机推理技术面临的一大挑战。

2. 批处理推理场景的适配

在实际应用中,批处理推理可以提高系统的整体吞吐量。投机推理本质上来说是用空闲的算力换取更高的吞吐,需要处理好投机模型和投机框架引入的耗时,不然无法发挥投机推理在批处理场景下的加速潜力。

另一方面,仅有投机推理技术也不够,推理性能提升还需与模型压缩、量化、增量式解码等有效集成。

超大规模MoE动辄百亿、千亿参数量,对显存带宽、计算能力和互联网带宽需求,提出了极高要求。尤其长序列推理中的KV cache,更是堪称显存「无底洞」。

在此背景下,量化技术 就成了缓解资源约束、优化部署效率的「救命稻草」——在大幅降低资源占用的同时,还能尽量保留模型精度。

以INT8量化为例:

权重量化可以将模型参数的显存需求降低50%,配合激活值量化,利用Cube-Core的INT8算力加速矩阵乘运算。KV cache量化则进一步压缩了显存占用,支持更长的序列和更高的并发请求,大幅提升了Decode阶段的系统吞吐量。尽管低比特量化被视为LLM推理的灵丹妙药,但若要实现高质高效的量化,并非易事。

1. 精度的损失

将模型参数从高精度压缩到低精度,不可避免会导致精度下降。尤其是,在极低比特数(如二值)情况下更为明显。

2. 算法的「两难抉择」

如何去设计高效、抗噪的量化算法,在保持精度同时,降低计算和访存复杂度,依旧是行业研究重点。

过于复杂的算法,虽能提升精度,但会增加计算开销,抵销量化的效率优势。而过于简单的算法,又会牺牲过多精度,最终导致模型效果不佳。

3. 硬件兼容的适配

量化后的模型还需与硬件深度适配,而现有的量化算法在昇腾硬件上还有很多创新优化的空间。

此外,量化误差的控制和推理过程中的动态调整策略,也充满了挑战。

4.校准集泛化性缺失

校准集的泛化性缺失导致了在很多任务上,难以达到与原有模型相近的精度水平,甚至在某些场景下精度下降十分严重。

不论是投机推理,还是低比特量化,都是推理优化过程核心,它们所面临的难题,是LLM飙速推理路上最大的绊脚石。

而现在,华为的这套方案,彻底攻克所有挑战,解锁了AI模型的中国速度。

投机推理框架FusionSpec

创1ms奇迹

具体来说,在投机推理方面,华为团队提出了投机推理框架FusionSpec 。

FusionSpec充分利用了昇腾服务器高计算带宽比的特点,在低时延大并发场景下,深度优化了DeepSeek提出的MTP在昇腾上的推理性能,将投机推理框架耗时减小至1ms,并在三个方面进行了重大创新:

1. 考虑到DeepSeek的模型架构,MTP层需要主体模型的最后一层结果作为输入,将MTP层的执行直接排在主体模型执行之后。

这样做带来两个优势:

优化后的调度顺序避免了推理的步间数据传输在PD分离的部署场景下,投机模型的后置解耦了PD分离系统与投机框架,同时有效减少了节点间的数据传输

昇腾基于PD分离部署的vLLM框架调度示意图

2. 参考MTP层训练模式,将MTP层视为模型的一部分,注意力算子复用主体模型的控制参数。

DeepSeek V3/R1为代表的主流的大语言模型采用旋转位置编码RoPE。在使用投机模型进行预测时,会按实际推理的token个数进行位置编码。

但对MTP层而言,计算时会忽略输入的第0个token。因此,研究团队把MTP层输入的第0个token舍去,前移其余token,并复用主体模型的控制参数。

而RoPE保证了对所有token进行平移后的attention score不发生改变。这样,就可以保证MTP层的正确计算,同时节省CPU上的准备时间,并简化整个系统的block管理。

· 参数复用省去了控制参数的重新构造,降低了框架耗时

通过主体模型前置与流程拼接,将单步投机推理中输入准备从两次降低为一次,避免主体模型和投机模型之间CPU同步打断流水,压缩了单步推理内主体模型与投机模型间的框架耗时,使得投机推理的整体框架时延与非投机场景一致。

基于上述优化,FusionSpec框架实现了在较低时延下的高并发、大吞吐。

3. 实现了NPU上的轻量步间准备,支撑了vLLM v0的multi-step以及vLLM v1前后处理全异步,进一步降低了步间的框架耗时。

除了模型结构和框架设计优化外,在算子级别的细化加速同样关键——这就是FusionSpec进一步优化的重点。

· 投机场景MLA算子加速

DeepSeek提出的对多头潜注意力机制MLA,通过对Key和Value的低秩联合压缩,不仅大幅减少了所需的KV缓存量,同时性能还超过了传统的MHA。

为了充分利用昇腾的计算能力,压缩端到端输出时间,FusionSpec进一步优化了投机场景MLA计算流程,减少矩阵的搬运时间。

投机场景下多头潜在注意力MLA算子优化

· TopK、TopP算子加速

在投机推理场景中,若预测m个token,单步推理需进行1+m次词表采样操作,所以采样操作的速度变得更加重要。

采样操作一般包含温度、TopK、TopP三步,其中TopK、TopP需要排序,并且计算前缀和,这些是采样操作的瓶颈。

未来,FusionSpec将采用流式过滤策略、昇腾归并排序API优化TopK、TopP计算。

量化框架OptiQuant

让MoE巨兽飞起来

在量化方面,华为团队则提出了OptiQuant量化框架。

它不仅兼容业界主流量化算法,通过一系列功能创新,为高效部署提供了强力支撑。具体来说,它有四大核心亮点:

· 丰富的量化和数值类型

OptiQuant支持了Int2/4/8和FP8/HiFloat8等数据类型,与业界Qserve、HQQ、LUT等主流量化方法兼容。

在此基础上,OptiQuant创新性提出「可学习截断」、「量化参数优化」等算法,将量化误差进一步降低。

· 业内主流评测数据集

OptiQuant支持多样化评测任务,包括判断题、问答题、代码题和数学题等多个方向,覆盖了十种常见的语言。

为了提升量化模型的泛化能力,OptiQuant还引入了混合校准集的方法,按一定的比例混合不同数据集。

· 量化权重以及元数据的生成

OptiQuant提出了自适应层间混精算法和PD分离量化权重,并且根据对应的量化配置生成对应的权重参数,通过去冗余技术减少参数保存的参数量。

同时,FlexSmoothQuant等算法在数据校准过程中,将搜索到的元数据进行保存,并用于后续推理过程。

· 量化权重推理

OptiQuant提出了KVCache量化和MoE TopK专家剪枝技术。

结合昇腾亲和的量化算子,OptiQuant通过高效数据并行/流水并行,针对不同大小的大语言模型实现精度验证性能加速,将对各个数据集精度评估性能提高了5x以上。

此外,OptiQuant还支持Vector Quantization、DFloat11、可逆变换、量化模型微调等技术点。

OptiQuant量化框架

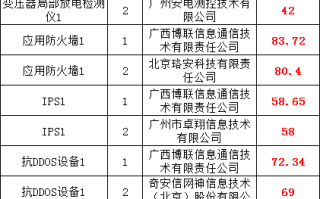

通过OptiQuant和相关优化算法,华为实现了W8A8C16/W4A8C16的模型精度,媲美FP8精度的效果,并充分发挥了昇腾硬件性能。

表1:DeepSeek-R1模型精度测试结果

注1:如无特殊说明, 测试为单次结果

注2:测试3次以上结果取平均

注3:单次测试结果

表2:DeepSeek-V3-0324模型精度测试结果

注1:单次测试结果

下一步,团队还将探索PD差异量化、KV cache量化、TopK专家剪枝、通用的等价变换建模、和量化微调等方向,实现更高效、更低比特的权重、激活和KV cache的量化模型推理技术。

总而言之,FusionSpec和OptiQuant的双剑合璧,将为超大规模MoE模型推理开辟了全新路径。

这两大框架的提出,打破了LLM推理的延迟魔咒、资源瓶颈。

这不仅仅是一次技术的突破,更是中国AI在全球舞台上的一次强势发声。

未来,FusionSpec推理框架和OptiQuant量化框架有机融合,将促使更多的创新涌现出来。

技术报告:

FuionSpec: https://gitcode.com/ascend-tribe/ascend-inference-cluster/blob/main/FusionSpec/%E6%98%87%E8%85%BE%E9%AB%98%E5%90%9E%E5%90%90%E6%8A%95%E6%9C%BA%E6%8E%A8%E7%90%86%E6%A1%86%E6%9E%B6FusionSpec.pdf

OptiQuant: https://gitcode.com/ascend-tribe/ascend-inference-cluster/blob/main/OptiQuant/OptiQuant-%E6%98%87%E8%85%BE%E4%BA%B2%E5%92%8C%E7%9A%84DeepSeek%E6%A8%A1%E5%9E%8B%E9%87%8F%E5%8C%96%E6%8A%80%E6%9C%AF.pdf

技术博客:

FusionSpec: https://gitcode.com/ascend-tribe/ascend-inference-cluster/blob/main/FusionSpec/ascend-inference-cluster-fusionspec.md

OptiQuant: https://gitcode.com/ascend-tribe/ascend-inference-cluster/blob/main/OptiQuant/ascend-inference-cluster-optiquant.md

相关问答

华为亮相“黑科技”,谁是下一个5倍的润和?

明天华为大会召开,华为鸿蒙3.0版发布。在周五中午的股文里已明确提示,下午的交易中,可密切关注鸿蒙概念股数字认证,润和软件。虽然说明天利好落地,鸿蒙概...虽...

华为有什么黑科技?

华为主要发力的领域还是在ICT这块,手机的话,其实不如三星苹果的,实事求是,但ICT领域。华为无疑是全球领导者之一,值得国人自豪。华为产品实在太多,黑科技...

华为有什么黑科技还没拿出来?

华为5G通信已经基本确定~占有一部分优势~后续继续努力会更好~CPU方面如果华为没有自主研发CPU架构~或是只能通过工艺手段提升性能的话就会出现短暂的昙花一现...

华为mate40e都有哪些黑科技?

全球首款5纳米5GSoC旗舰芯片麒麟9000系列,让全场景智慧联接生活再一次充满想象。EMUI11分布式技术的全新多屏协同,以多设备协同操作、数据流转和多屏操控能...

华为Mate50Pro在强大黑科技加持下,到底有多强?

现在说华为Mate50Pro还为时过早,说不定华为自己内部都还没有定下最终方案,再一结合老美的封锁,能顺顺利利的生产上市就不错了,不要再自嗨强大黑科技了!第一...

华为p40有什么黑科技?

多谢邀请!华为P40手机有什么黑科技呢?对于华为P系列手机来说,主打拍照体验,一般拍照效果属于顶级的存在。实际上对于华为每一代P系列手机来说,是有多个机...

华为mate40rs保时捷黑科技?

华为Mate40RS保时捷设计版和标准版的主要差异在于机身的背部设计上,即便只看图片,我们也能一眼就看到它机身后壳上棱角分明的线条设计,但只有真正上手的用户...

华为黑科技-ZOL问答

123条回答:2024年中国家电及消费电子博览会(AWE2024)正在火热进行中,华为本次展区位于上海新国际博览中心W4馆的4C11/4C31,ZOL中关村在线将带着大家一起来看看华...

华为nova85g有哪些黑科技?

散热功能nova8采用了3D石墨烯散热膜散热技术,可迅速感应升温区域,并即刻降温,在拍摄、玩游戏和追剧之中感受出色散热。2.拍摄功能多个视频故事创作模板,...

华为黑科技Cyberverse,怎么样?

近日,在华为开发者大会期间,华为罗巍正式对外发布了“Cyberverse”。Cyberverse由cyber(Cyber数字)和verse(universe宇宙)构成,寄托了这一功能“开启数字新世....